ContextShift:€8 64MB Xen VPS

2010年03月8日 | 标签: xen

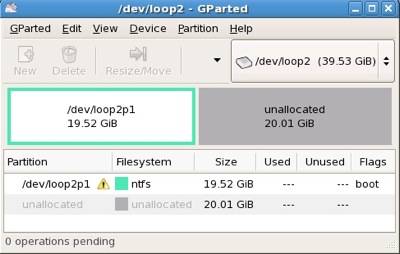

ContextShift 是荷兰阿姆斯特丹的一家 VPS provider,他家的 VPS 较贵 64MB 就要5欧,前几天的 WeServIT:128MB Xen VPS 只要5欧,更夸张的是 ContextShift 的 VPS 还要9欧的 setup fee(连续订购3个月的话可以免掉 setup fee),setup fee 只在 dedicated server 里面听说过,在 VPS 里面不多见。不过这个东西也说不好,说不定人家 “贵” 的有理由呢。他家 VPS 没有提供 SWAP,不过可以自己在系统里添加 swap 文件的方式添加 SWAP. VPS 配置如下:

服务器在荷兰或英国

5GB 硬盘

64MB RAM

25GB 带宽

8欧元

服务器和网络信息:

AMD Opteron CPUs, ECC error correcting memory, RAID1 (mirrored) storage and dual gigabit network connections.