CpanelHost:$10 512MB OpenVZ VPS

2009年10月25日 | 标签: vps

CpanelHost 网站上没有给太多有用的信息,估计是刚建不久,whois 查询显示域名是在今年8月份注册的。根据 WHT 的广告信息,目前这款 VPS 正在优惠中,每个月只要5美刀。他们家 VPS 还提供 FreeBSD 系统,可是他们也提到他们用的是 OpenVZ,不知道 FreeBSD 是不是运行在 VMware 上的。VPS 配置如下:

服务器在 Scranton, PA

vePortal 控制面板

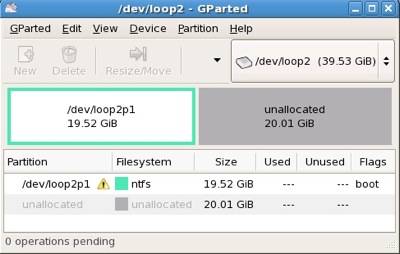

20GB 硬盘

512MB Guaranteed RAM

1000GB 带宽

2个 IP

10美元