Fake RAID 不能碰

2009年11月4日 | 标签: raid

上个月和硬盘一起订购的内存条终于到了,16根 Sun 服务器原装 2GB DDR2 667 (PC2 5300) ECC 内存条用来升级4台 Sun Fire X2100 M2,升级后每台 8GB,可惜 X2100 M2 只有4个插槽,每个插槽最大只支持 2GB DIMM. 第二批内存还在等待中,用来升级部分 X2200 M2, X2200 M2 有16个内存插槽,每个插槽可以支持 4GB DIMM,最大可以使用 64GB.

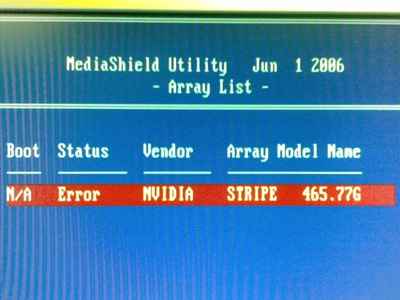

今天升级内存出现问题,不知道什么原因开机后 Nvidia RAID 报错:

上个月用服务器自带的 Nvidia RAID 做了双硬盘 RAID0,现在系统启动不了了,提示找不到硬盘。解决办法是把当前的 RAID array 删除后重建一个,千万不能选择 “clear data”,然后重启后发现 Linux 内核可以启动但是不能挂载 root,检查 grub 发现系统的时候企图启动挂载原来的 raid 分区 root=/dev/mapper/nvidia_bfbbbhdf2,但是重建 raid 后设备名称改了,所以应该挂载新的设备名到 root:

# mkdir /mnt # mount -t ext3 /dev/mapper/nvidia_ebhbbgdh2 /mnt/

挂载后就可以看到原来的硬盘内容了,也可以使用原硬盘的程序了,用 vi 修改 grub:

# /mnt/bin/vi /mnt/boot/grub/menu.lst root=/dev/mapper/nvidia_ebhbbgdh2

重启后就应该可以正常启动了,有惊无险。使用 RAID0 是非常危险的举动,坏个硬盘、控制器什么的整个系统数据就受到威胁,运气不好就会丢失所有数据。不过既然要做 RAID0,早就应该有心理准备和打算,并且任何时候都不能应用 RAID0 到关键服务器上,如果一定要做 RAID 的话首选硬件 RAID,其次是 Linux software RAID,最好不要碰 Fake RAID,冗余方式推荐 RAID10 和 RAID5。